itmo_conspects

Технологии программирования на Java

- Технологии программирования на Java

Этот курс будет про работу с языком Java (JVM, ООП на Java), с базами данных, со средствами сборки и тестирования, с микросервисами

Первый модуль будет посвящен изучению Java (дополнительно можно ознакомиться на сайте Георгия Корнеева), второй модуль - Spring и микросервисам

Презентации лекций доступны здесь - https://xrem.github.io/tech/

Лекция 1

До этого появления Java существовали большие компьютеры, кушающие перфокарты; далее появились такие древние языки, как FORTRAN, BASIC и другие

Основной недостаток: ни один из представленных в те времена ЯП не мог удовлетворить одновременно всем критериям:

- простота использования

- предоставляемые возможности

- безопасность

- эффективность

- устойчивость

- расширяемость

Первый таким языком стал C - он был создан для работяг, тогда как более старые языки были созданы в академических целях

Потом появился C++, объединивший в себе ООП, однако C++ - платформо-зависимый язык

К 90-ым годам с распространением компьютеров появились разные платформы. С этим появилась концепция превращения кода в промежуточную стадию, которую можно запускать на процессорах разных архитектур. Ввели термины managed code (управляемый код) и unmanaged code (неуправляемый код). Управляемый код управляется средой выполнения - виртуальной машиной.

В Java код переводится в байт-код, который транслируется в машинные инструкции при помощи Java Virtual Machine (JVM). При этом понимание Java-программисту устройства виртуальной машины также не нужно, как и понимание устройства компилятора C-программисту (*тык*)

Java Runtime Environment (JRE) - среда выполнения для Java, которая содержит библиотеки классов, загрузчик классов и т. д.

Java Development Kit (JDK) - средства, позволяющие разрабатывать на Java

JVM состоит из:

-

спецификации - набором правил, диктующих, как должна быть реализована JVM. “JVM должна правильно запускать программы, написанные на Java”

-

реализации - реальной программы, которая будет запускать и позволять разрабатывать программы, написанные на Java

-

экземпляра - оболочки над вашим кодом, которая его исполняет и заботится о том, как она это делает

Пример кода на Java:

package ru.butenko.springdatatest; // название пакета

import java.time.LocalDate;

public class Dog {

public String name;

private LocalDate birthdate;

public int calculateAge() {

return LocalDate.now().getYear() - this.birthdate.getYear();

}

}

В названии пакета отражается название организации (или индивидуального человека), название проекта и файловая структура проекта

При компиляции класс из файла .java переводится в байт-код .class

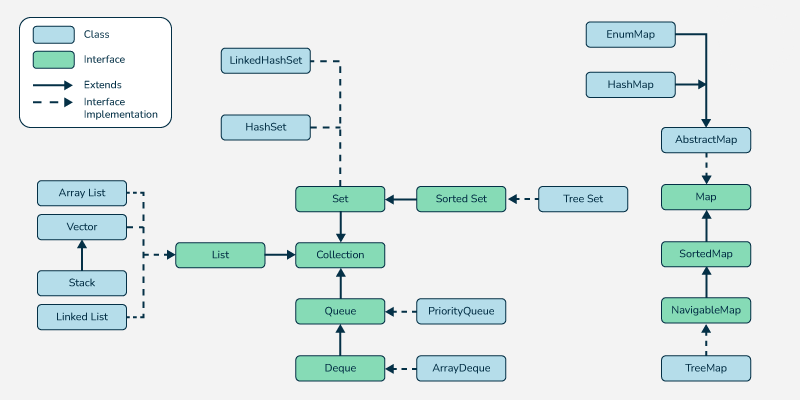

Также в Java есть примитивные коллекции, например, Queue, Deque и другие (*тык*)

Ошибки в Java делятся на 2 типа:

-

___Error- ошибки, связанные с JVM -

___Excetion- исключения, связанные с работой кода

Если метод может вызвать исключение во время работы, то оно должно быть указано в сигнатуре метода:

public void Do() throws Exception {

...

}

Также хорошим тоном будет указывание документации для классов и методов:

import java.time.LocalDate;

/**

* Класс "Собака"🐶

*/

public class Dog {

public String name;

private LocalDate birthdate;

/**

* Метод, вычисляющий возраст собаки

*

* @return int возраст собаки

*/

public int calculateAge() {

return LocalDate.now().getYear() - this.birthdate.getYear();

}

/**

* Метод, дающий собаке новое имя

*

* @param String новое имя собаки

*/

public void setName(String newName) {

name = newName;

}

/**

* Метод, вычисляющий возраст собаки

*

* @throws Exception исключение

*/

public void DoException() throws Exception {

throw new Exception("Yay!");

}

}

Лекция 2

Сейчас версией с долгосрочной поддержкой является Java 21

Разберемся в изданиях Java:

-

Java Platform Standard Edition (Java SE) - стандартная редакция Java, которая использует для разработки простых приложений

-

Java Platform Enterprise Edition (Java EE) - редакция для предприятий

-

Java Platform Micro Edition (Java ME) - редакция для разработки ПО на микроконтроллерах, мобильные платформы и т.д.

Комитет Java Community Process определяет, как будут выглядеть будущие спецификации Java

Классы в Java как правило объединены в пакеты. По умолчанию, стандартная библиотека Java содержит пакеты java.lang, java.io, java.util и другие. Организация классов в пакеты позволяет избежать коллизии имен.

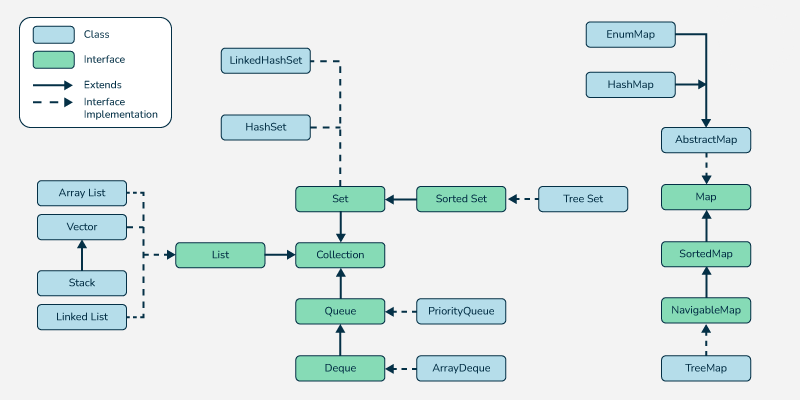

В Java все коллекции представлены в Java Collections Framework наследуются от интерфейса java.util.Collection. Сам интерфейс java.util.Collection наследуется от интерфейса java.util.Iterable, позволяющий итерироваться по коллекции.

В Java в качестве динамического списка используют ArrayList (с произвольным доступом по индексу) и LinkedList (с последовательный доступом)

Vector в Java работает так же, как и ArrayList, но Vector потокобезопасный. Также Vector расширяется вдвое, а ArrayList в 1,5 раза

Помимо них есть:

-

Stack- стек, реализованный наVector -

Queue- односторонняя очередь -

Deque- двухсторонняя очередь -

Set- множество; реализации на хеш-таблицеHashSetи на деревеTreeSet -

Map- словарь; реализации на хеш-таблицеHashMapи на деревеTreeMap

В java.util.concurrent существуют потокобезопасные версии коллекций

Помимо Java Collections Framework другие фреймворки, такие как Google Guava и Apache Commons Collections, реализуют свои коллекции

Чтобы обрабатывать коллекции, в Java есть Stream API. Работает он как LINQ в C#:

-

Создаем поток из коллекции:

list.stream() -

Применяем промежуточные методы, такие как

filter(),map(),sorted() -

Применяем терминальный метод, например,

count(),findFirst(),toList()

Пример:

list

.stream()

.filter(x -> x.toString().length() == 3)

.forEach(System.out::println);

list.stream().forEach(x -> System.out.println(x));

Лекция 3

По мере роста количества кода появилась потребность в системах сборки, которые связывают необходимые библиотеки с проектом. Впоследствии понадобилась автоматизация сборки, чтобы система сама находила зависимости, скачивала их, прогоняла тесты и деплоила на удаленный сервер

В начале единственным приличным инструментом для сборки был Make, позднее потребовались более функциональные инструменты для сборки. Сейчас можно выделить 3 популярные системы сборки для Java:

- Apache Ant и Apache Ivy

- Apache Maven

- Google Gradle

Apache Ant + Apache Ivy

Ant вышел в 2000 и был первым среди “современных” инструментов сборки. Для описания сборки Ant использует информацию, написанную в build.xml:

<project>

<target name="clean">

<delete dir="classes"/>

</target>

<target name="compile" depends="clean">

<mkdir dir="classes"/>

<javac srcdir="src" destdir="classes"/>

</target>

<target name="jar" depends="compile">

<mkdir dir="jar"/>

<jar destfile="jar/HelloWorld.jar" basedir="classes">

<manifest>

<attribute name="Main-Class"

value="antExample.HelloWorld"/>

</manifest>

</jar>

</target>

<target name="run" depends="jar">

<java jar="jar/HelloWorld.jar" fork.="true">

</target>

</project>

Позднее для управления зависимостями появился Apache Ivy. Ivy автоматически ищет в указанном репозитории указанные зависимости и скачивает их.

Во время сборки Ant делает 4 вещи (фазы, цели):

- clean - очистка предыдущих файлов сборки

- compile - компиляция

- jar - упаковка в jar архив

- run - запуск JVM

Apache Maven

Maven вышел в 2004 и стал преемником Ant и Ivy, сочетая в себе функционал этих инструментов. Maven умеет управлять зависимостям, которые загружены на репозиторий Maven Central

В отличии от Apache Ant, Maven требует строгой файловой структуры проекта:

project

|_ src

| |_ main

| | |_ java

| | |_ resources

| |_ test

| |_ java

| |_ resources

|_ target

|_ pom.xml

Управлять сборкой в Maven можно с помощью pom.xml файла (Project Object Model). В ней

<?xml version="1.0" encoding="UTF-8"?>

<project xmlns="http://maven.apache.org/POM/4.0.O"

xmlns:xsi="http://www.w3.org/2001/XMLSchema-instance"

xsi:schemaLocation="http://maven.apache.org/POM/4.O.O

http://maven.apache.org/xsd/maven-4.O.O.xsd">

<modelVersion>4.0.0</modelVersion>

<groupId>example.com</groupId>

<artifactId>example</artifactId>

<version>1.0-SNAPSHOT</version>

<dependencies>

<dependency>

<groupId>commons-io</groupId>

<artifactId>commons-io</artifactId>

<version>2.6</version>

</dependency>

</dependencies>

</project>

Тег modelVersion указывает на версию Maven, теги groupld, artifactId, version указывают название и версию нашего артифакта (артифактом будем называть приложение, модуль, библиотему, jar-файл и прочее). В теге dependencies в том же формате указаны зависимости нашего проекта, которые будут загружаться из Maven Central

Чтобы изменить структуру проекта, в Maven придумали архетипы - шаблоны проектов. С помощью архетипов можно создать готовые шаблоны проектов для библиотек, для веб-приложений, для плагина и т.д.. Чтобы посмотреть доступные архетипы, можно выполнить команду mvn archetype:generate

Так же как и Ant, Maven обладает своим жизненным циклом

| Фаза | Описание |

|---|---|

| validate | Проверка корректность метаинформации о проекте |

| compile | Компиляция файлов |

| test | Проверка тестов на скомпилированных файлах |

| package | Упаковка в артефакт вида jar, zip и т.д. |

| verify | Проверка артефактов |

| install | Коммит артефакта в локальный репозиторий |

| deploy | Деплой на продакшен или удаленный репозиторий |

Жизненный цикл можно расширять при помощи плагинов. Плагины устанавливают при помощи изменения pom.xml:

<plugins>

<plugin>

<groupId>org.apache.maven.plugins</groupId>

<artifactId>maven-checkstyle-plugin</artifactId>

<version>2.6</version>

</plugin>

</plugins>

Google Gradle

Google Gradle был выпущен в 2008 году для облегчения разработки Java-приложений на Android. Вместо громоздкого XML система сборки Gradle поддерживает два языка для описания сборки: предметно-ориентированные языки Groovy и Kotlin.

В качестве репозитория зависимостей Gradle поддерживает репозитории Ivy, Maven Central и другие.

Так как Gradle постоянно меняется и может не иметь совместимость между собой, существует Gradle Wrapper: скрипт grablew автоматически скачивает нужную версию Gradle, которая указана в build.gradle. Сам build.gradle, информация о проекте, выглядит так:

plugins {

id 'application'

}

repositories {

mavenCentral ( )

}

dependencies {

testImplementation 'org.junit.jupiter:junit-jupiter:5.9.1'

implementation 'com.google.guava:guava:31.1-jre'

}

application {

mainClass = 'demo.Арр'

}

tasks.named('test') {

useJUnitPlatform()

}

Или же можно создать build.gradle.kts, где указать то же самое, только на Kotlin:

plugins {

application

}

repositories {

mavenCentral ( )

}

dependencies {

testImplementation("org.junit.jupiter:junit-jupiter:5.9.1")

implementation("com.google.guava:guava:31.1-jre")

}

application {

mainClass.set("demo.Арр")

}

tasks.named<Test>("test") {

useJUnitPlatform()

}

Как и Maven, Gradle поддерживает плагины и имеет похожий цикл сборки

Лекция 4

Сборка мусора - процесс восстановления заполненной памяти среды выполнения путем уничтожения неиспользуемых объектов

В таких языках, как C и C++, программист сам отвечает за жизненный цикл объектов. В случае, если выделенная память для созданного объекта в конце его жизненного цикла не освобождается, то возникает утечка памяти:

void foo() {

// выделили память для 100 символов

char* array = new char[100];

// выделили память еще раз, перезаписали старый указатель,

// те самым потеряв к старому массиву доступ

array = new char[100];

}

Чтобы облегчить жизнь программиста и направить всю его концентрацию на создание бизнес-логики, придумали автоматическое управление памятью

В Java автоматическим управлением памятью занимается среда JVM. JVM по надобности выделяет нужный участок памяти на куче, в которой хранятся переменные, созданные программистом, и занимается сборкой мусора, то есть освобождением памяти уже ненужных переменных.

Перед сборщиком мусора (Garbage Collector) стоят 2 задачи:

- Обнаружение мусора

- Очистка мусора

Мусором мы будем считать объекты, ссылки на которые были утрачены, то есть доступ к нему невозможен

Обнаружение мусора

Есть 2 способа обнаруживать мусор:

- Счетчик ссылок (Reference counting)

- Трейсинг (Tracing)

Счетчик ссылок считает количество живых ссылок на объект. Если число ссылок достигает 0, то объект удаляется (подобно shared_ptr в С++). Несмотря на простоту, счетчик ссылок плохо сочетается с многопоточностью и без дополнительных алгоритмов не может выявлять циклические ссылки (объекты ссылаются друг на друга => счетчики не нулевые)

Трейсинг основан на графе объектов и его обхода. Для начала вводится понятие корневой точки (GC Root). Корневой точкой мы будем считать локальные переменные, статические переменные, потоки, ссылки из Java Native Interface и т.д.. Затем строится дерево ссылок. Мусором считается тот объект, до которого нельзя попасть из корневых точек.

Компилятор знает, когда заканчивается скоуп, в котором живет переменная, поэтому при выходе из скоупа (тела функции, цикла и т.д.) корневые точки прекращают свое существование (за исключением тех, что были возвращены функцией). Пример:

public House doSomething(string[] args) {

Person person = new Person("Ivan");

person.setHouse(new House());

person.getHouse().setRoof(new Roof());

person.getHouse().setDoor(new Door());

Person person1 = new Person("Michael");

Person person2 = new Person("John");

person1.setFriend(person2);

person2.setFriend(person1);

return person;

}

Получаем такой лес объектов:

person

|- house

|- roof

|- door

person1

|- person2

|- ...

person2

|- person1

|- ...

После return объект person остается жить, потому что он был возвращен, а person1 и person2 - нет. Несмотря на то, что количество ссылок на них ненулевое количество, из корневых точек в них попасть мы не можем (а таковым они перестают считаться после return)

Очистка мусора

От сборщика мусора нам нужно, что бы он:

- за предсказуемое время завершал свою работу (Latency and Responsiveness)

- не потреблял много оперативной памяти (Memory Footprint)

- не требовал большего количества вычислительных ресурсов (Throughput)

Добиться всех трех свойств нереально, поэтому то, что сейчас есть - это компромиссы между ними

Существует несколько алгоритмов очистки мусора. Один из них - копирующая сборка

Для копирующей сборки память условно делится на две части: from-space и to-space. Сначала объекты попадают в from-space. Когда она заполняется, происходит stop-the-world (остановка мира), сборщик мусора проходится по объектам, копирует нужные объекты в to-space, а ненужные высвобождаются. После этого области памяти from-space и to-space меняются местами (свапаются указатели)

Stop-the-world гарантирует, что во время очистки не выделится память для новых объектов, тем самым граф объектов будет заморожен

Другим методом является “отслеживание и очистка” (Mark and Sweep). При помощи трейсинга сборщик мусора помечает живые объекты и во время остановки мира пробегается по всем объектам и удаляет те, которые не были помечены живыми. После очистки объекты могут располагаться по всей памяти, тем самым фрагментируя ее. Дополнительно может производиться дефрагментация памяти (такой алгоритм называют Mark and Sweep Compact): сдвиг живых объектов в самое начало. Заметим, что дефрагментация - очень дорогая операция.

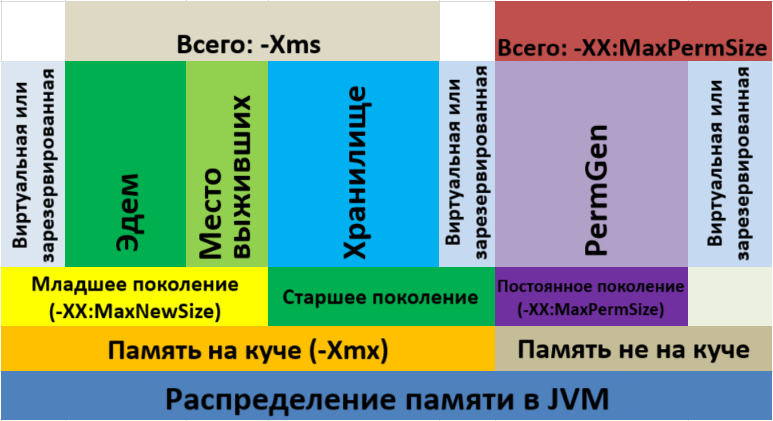

Еще один алгоритм основывается на так называемой “слабой гипотезе о поколениях”. В процессе наблюдения заметили, что объекты либо живут очень мало, либо очень много, причем чаще всего объекты из одной группы почти никак не связаны с объектами из другой.

Будем говорить, что быстроживущие объекты принадлежат младшему поколению (young generation), а долгоживущие - старшему поколению (old generation). Наблюдения привели к тому, что большинство объектов принадлежат младшему поколению (итераторы, локальные переменные и т.д.), тогда как если объект принадлежит старшему поколению, то ненужным он будет совсем не скоро.

Поэтому имеет смысл сделать три типа очистки:

- minor - очистка объектов из младшего поколения

- major - очистка объектов из старшего поколения

- full - очистка всех объектов

Сразу оговоримся, что мы рассматриваем алгоритм, реализованный в HotSpot JVM. Реализация может очень сильно отличаться от виртуальной машины и выбранного сборщика мусора.

Тогда мы можем разделить нашу память на 3 части:

- Эдем (Eden) - здесь хранятся только что созданные объекты

- Пространство выживших (Survivor Space) - здесь хранятся объекты, выжившие одну очистку мусора и перешедшие сюда из Эдема. Survivor Space делится на 2 части, S0 и S1, между которыми работает копирующая сборка

- Хранилище (Tenured) - здесь хранятся объекты старшего поколения

До Java 8 память JVM выглядела так:

Помимо выше указанных существовала область PermGen - постоянное поколение. Там хранились метаданные о классах, и располагалась она на стеке. С Java 8 эту область решили назвать MetaSpace и перенести на кучу

Таким образом, Minor сборка мусора начинается с тех пор, как заполняется Эдем. Из Эдем выжившие объекты переходят в Пространство выживших. В Major сборке очищается хранилище

Сборщики мусора, основывающиеся на поколениях, называют Generational Garbage Collector

Реализации сборщиков мусора

Разберем некоторые реализации сборщиков мусора из HotSpot JVM

Serial GC

Простенький сборщик мусора для однопоточных приложений. Во время работы останавливает все приложение, поэтому не рекомендуется в случае, когда необходимы минимальные задержки. Включается флагом -XX:UseSerialGC в JVM

Parallel GC

Сборщик мусора по умолчанию, работает в несколько потоках, во время работы останавливает все приложение. Включается флагом -XX:UseParallelGC

CMS GC

Concurrent Mark and Sweep сборщик работает как и Parallel GC, только сводится время остановки мира к минимуму засчет большего потребления ресурсов ЦП. CMS GC не выполняет дефрагментацию. Включается флагом -XX:UseConcMarkSweepGC

G1 GC

Garbage 1st GC работает как и CMS GC, только вместо разделения памяти на поколения, память разделена на набор областей, каждая из которых может представлять младшее либо старшее поколение. Используется в Minecraft👍. Включается флагом -XX:UseG1GC

Epsilon GC

Совсем ниче не умеет, используется, когда мусора в вашем коде нет. Сдается, когда память закончилась. Включается флагом -XX:UnlockExperimentalVMOptions -XX:UseEpsilonGC

Shenandoah GC

Работает как G1 GC, только с меньшими задержками и большими затратами на ЦП. Включается флагом -XX:UnlockExperimentalVMOptions -XX:UseShenandoahGC

ZGC

Используется, когда нужны очень маленькие задержки и когда есть очень много оперативной памяти. Использовать лучше на сервере с огромном оперативкой, а не на тостере. Включается флагом -XX:UnlockExperimentalVMOptions -XX:UseZGC

В целом, выбор сборщика мусора зависит от характера разрабатываемого приложения. Однако, если приложение небольшое, то лучше прислушаться к настройкам по умолчанию👍

Лекция 5

Архитектура большинства приложений состоит из трех уровней:

- клиентский

- промежуточный

- уровень доступа к данным

Для уровня доступа к данным существуют такие инструменты:

- Java Database Connectivity API (JDBC API) - низкоуровневое API для доступа к хранилищу данных. Типичное использование JDBC — написание SQL запросов к конкретной базе данных.

- Java Persistence API - интерфейс для доступа к данным и преобразования этих данных в объекты языка программирования Java и наоборот. Гораздо более высокоуровневое API по сравнению с JDBC.

- Java Transaction API - интерфейс для определения и управления транзакциями, включая распределенные транзакции, а также транзакции, затрагивающие множество хранилищ данных.

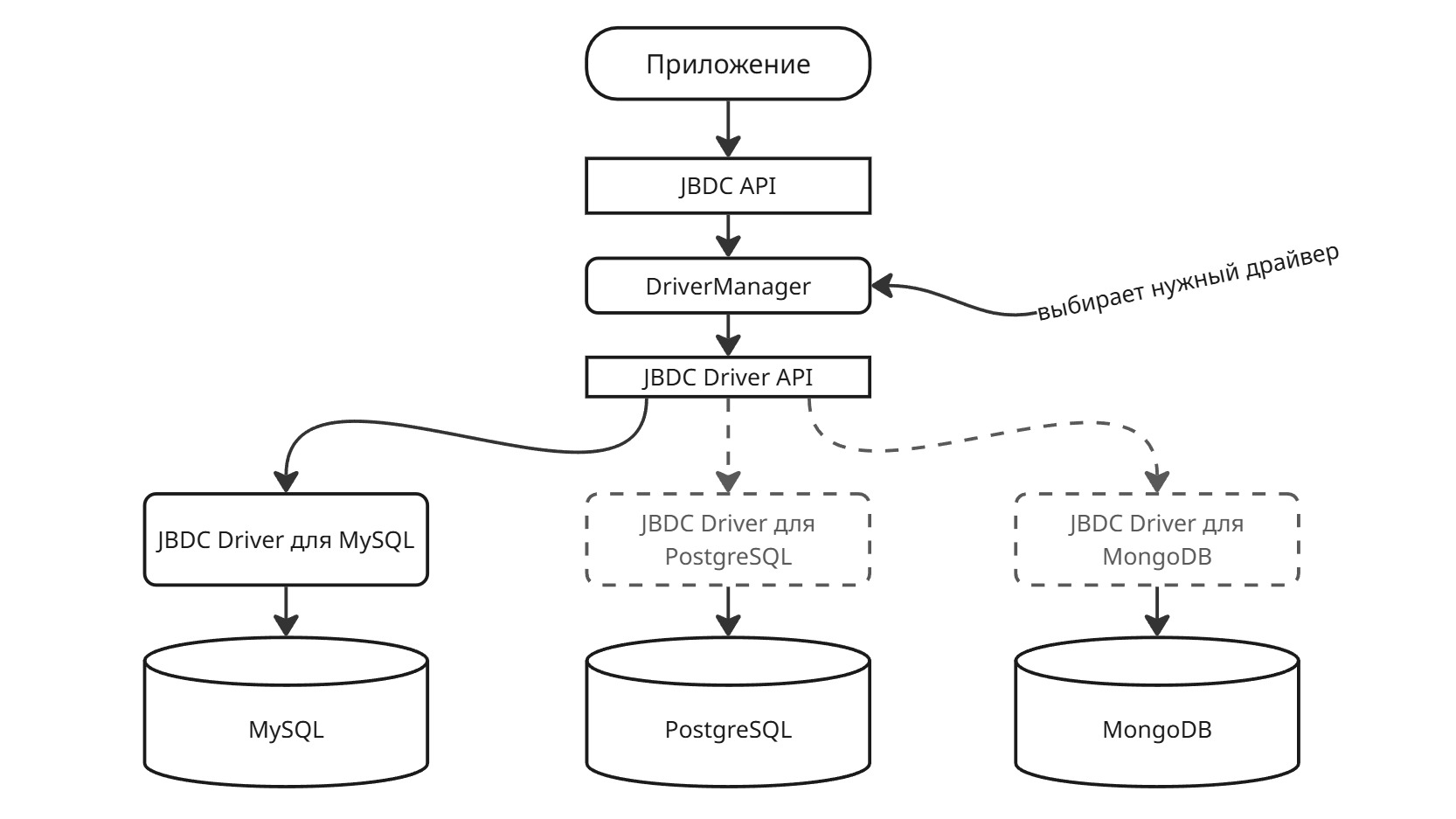

Java Database Connectivity

JDBC представляет собой общий интерфейс для доступа к базе данных. Для подключения используется менеджер драйверов:

Connection conn = DriverManager.getConnection(

"jdbc:mysql://localhost:3306/db_name",

"user", "password");

DriverManager сам выберет нужный драйвер для указанной базы данных (в данном случае mysql)

Чтобы сам класс нужного драйвера появился в проекте, используем менеджер зависимостей:

<dependency>

<groupId>mysql</groupId>

<artifactId>mysql-connector-java</artifactId>

<version>8.0.29</version>

</dependency>

dependencies {

implementation('mysql:mysql-connector-java:8.0.29')

}

Используя JDBC, с базой данных можно работать при помощи сырых SQL-запросов:

try (Connection conn = DriverManager.getConnection(

"jdbc:mysql://localhost:3306/db_name", "user", "password");

Statement stmt = conn.createStatement()) {

// SELECT-запрос

ResultSet rs = stmt.executeQuery("SELECT * FROM users");

// Выводим идентификаторы и имена пользователей

while (rs.next()) {

System.out.println(rs.getInt("id"));

System.out.println(rs.getString("name"));

}

// INSERT-запрос

int rows = stmt.executeUpdate("INSERT INTO users (name) VALUES ('John')");

System.out.println("Добавлено строк: " + rows);

} catch (SQLException e) {

e.printStackTrace();

}

Все SQL-запросы можно разделить на два типа:

- Получение данных - инструкции SELECT и другие

- Изменение данных - инструкции INSERT, UPDATE, DELETE и другие

Для первых запросов используется метод executeQuery(), который возвращает ResultSet, содержащий данные

Для вторых запросов используется метод executeUpdate(), возвращающий количество измененных строк

При помощи JDBC можно создать выполнимую процедуру внутри базы данных:

CallableStatement callableStatement =

connection.prepareCall("{call calculateStatistics(?, ?)}",

ResultSet.TYPE_FORWARD_ONLY,

ResultSet.CONCUR_READ_ONLY,

ResultSet.CLOSE_CURSORS_OVER_COMMIT

);

Такие функции выполняются на сервере базе данных, то есть выигрывают в производительности, так как работают в одном пространстве памяти

При желании альтернативно можно создать подключение через определенный драйвер для базы данных, объявив DataSource:

OracleDataSource Ods = new OracleDataSource();

ods.setUser("stud");

ods.setPassword("stud");

ods.setDriverType("thin");

ods.setDatabaseName("stud");

ods.setServerName("localhost");

ods.setPortNumber(1521);

Connection conn = ods.getConnection();

Методы и их количество могут отличаться от драйвера к драйверу

Здесь thin - тип драйвера. Всего существуют 4 типа:

- Первый тип (Type-1) или JDBC-ODBC bridge driver

- Второй тип (Type-2) или Native-API driver

- Третий тип (Type-3) или Network Protocol driver

- Четвертый тип (Type-4) или Thin driver

Если нужно обратиться к одному типу базы данных, предпочтительным типом драйвера является Type-4.

Если Java-приложение обращается к нескольким типам баз данных одновременно, Type-3 является предпочтительным драйвером.

Драйверы Type-2 полезны в ситуациях, когда драйвер Type-3 или Type-4 еще недоступен для вашей базы данных.

Драйвер Type-1 обычно используется только при разработки и тестирования.

Зачастую пользоваться JDBC неудобно, так как все запросы становятся хардкодом, а Java-разработчики могут не знать SQL. Поэтому появился JPA

Java Persistence API

Java Persistence API - спецификация, описывающая систему управления сохранением Java объектов в таблицы реляционных баз данных в удобном виде. Сама Java не содержит реализации JPA, однако есть существует много реализаций данной спецификации от разных компаний.

Заметим, что JPA - это не единственный способ сохранения Java-объектов в базы данных (Object-Relational-Model-систем), но один из самых популярных.

Hibernate - одна из самых популярных открытых реализаций JPA версии 2.1. Далее будем рассматривать ее, как реализацию JPA

Чтобы объявить персистентную сущность, объявим ее аннотацией @Entity

@Entity

// явно указываем, из какой таблицы принадлежит сущность

@Table(name = "users")

public class User {

// говорим, что id - это первичный ключ, который будет генерироваться сам

@Id

@GeneratedValue(strategy = GenerationType.IDENTITY)

private Long id;

// указываем, что имя столбца отличается от имени атрибута

@Column(name = "user_name")

private String name;

// связь многие-к-одному

@ManyToOne

@JoinColumn(name = "countries")

private Country country;

// геттеры, сеттеры, другие методы

}

По умолчанию, Hibernate будет искать сущести в базе данных по их именам атрибутов (то есть переводя camelCase полей классов в snake_case атрибутов базы данных)

Далее сущности указываются в так называемой единице персистентности (persistence unit) в файле resources/META-INF/persistence.xml:

<?xml version="1.0" encoding="UTF-8"?>

<persistence version="2.2"

xmlns="http://xmlns.jcp.org/xml/ns/persistence"

xmlns:xsi="http://www.w3.org/2001/XMLSchema-instance"

xsi:schemaLocation="http://xmlns.jcp.org/xml/ns/persistence

http://xmlns.jcp.org/xml/ns/persistence/persistence_2_2.xsd">

<!-- Здесь myunit - название группы сущностей -->

<persistence-unit name="myunit">

<description>

Описание

</description>

<!-- Здесь перечисляются сущности -->

<class>org.example.models.User</class>

<properties>

<!-- Данные для подключения -->

<!-- Здесь в качестве примера СУБД PostgreSQL и база данных с именем cats, находящаяся на localhost -->

<property name="hibernate.connection.driver_class" value="org.postgresql.Driver" />

<property name="hibernate.connection.url" value="jdbc:postgresql://localhost:5432/cast" />

<property name="hibernate.connection.username" value="${POSTGRES_USERNAME}" />

<property name="hibernate.connection.password" value="${POSTGRES_PASSWORD}" />

<!-- Настройка миграции -->

<property name="hibernate.hbm2ddl.auto" value="X" />

<!-- Вместо X подставить нужное значение:

validate - проверяет, что схема базы данных соответствует объектной модели, но не делает никаких изменений

update - обновляет схему с сохранением данных

create - создает схему, удаляя предыдущие данные

create-drop - создает схему, удаляя предыдущие данные, а также удаляет схему к концу сессии

-->

</properties>

</persistence-unit>

</persistence>

А чтобы работать с ними, используют EntityManager:

// Создаем EntityManager

EntityManagerFactory emf = Persistence.createEntityManagerFactory("myunit");

EntityManager em = emf.createEntityManager();

// Поиск по идентификатор

User user = em.find(User.class, 1L);

System.out.println(user.getName());

// JPQL-запрос

TypedQuery<User> query = em.createQuery(

"SELECT u FROM User u WHERE u.name LIKE 'A%'", User.class);

List<User> users = query.getResultList();

// Закрываем сессию

em.close();

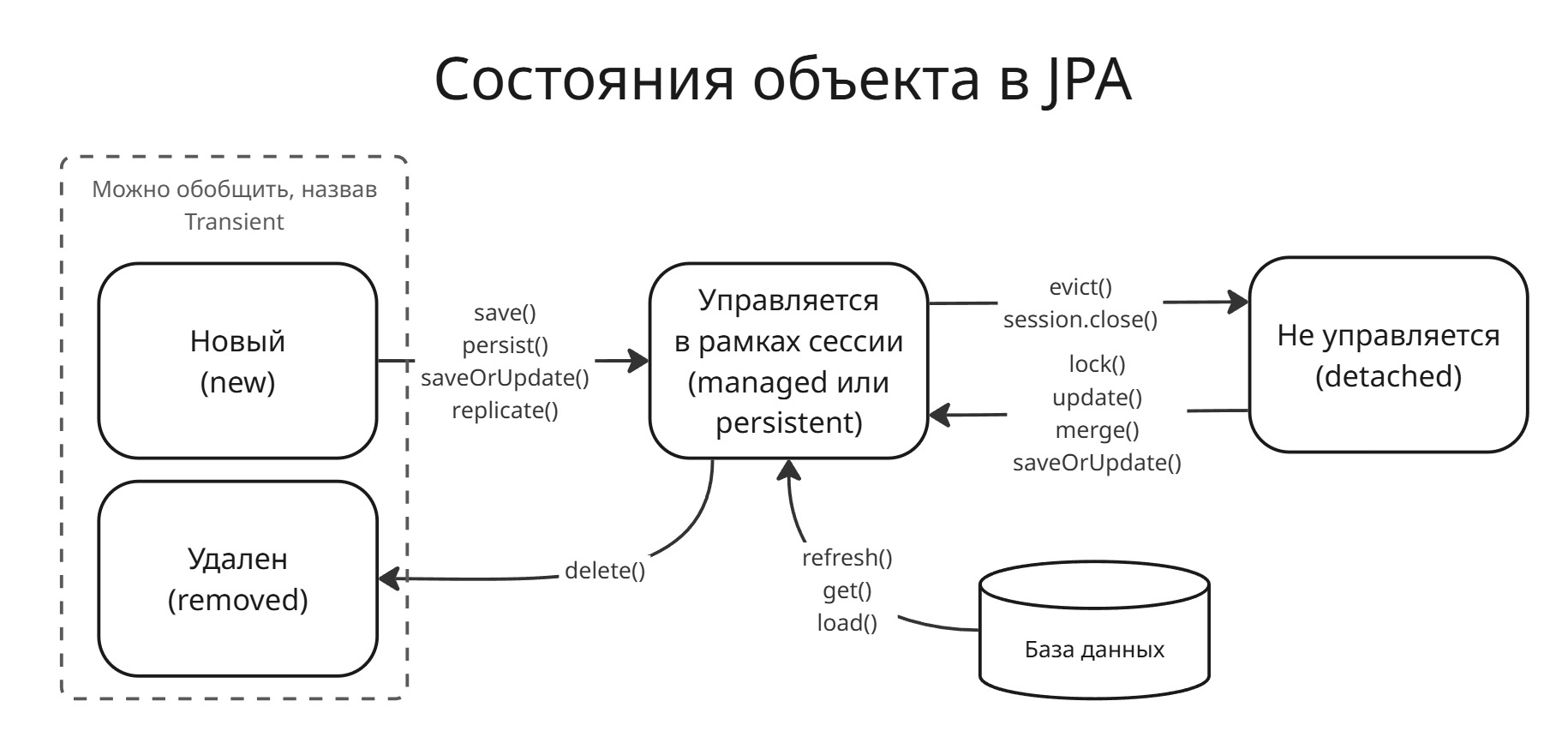

Сущности, включенные в JPA, имеют свое состояние:

- Новый объект - объект, созданный с помощью

new, но еще не имеет сгенерированный ключей и не хранится в базе данных - Удаленный объект - объект, который будет удален из базы данных после совершения транзакции

- Управляемый объект - объект, который управляется JPA

- Отсоединенный объект - объект, который существует в базе данных, но который не управляется JPA

Лекция 6

Spring Framework (или коротко Spring) — универсальный фреймворк с открытым исходным кодом для Java-платформы.

Spring является собой свободной альтернативной Java EE (или Jakarta EE), предоставляющая функционал для enterprise-разработки. Spring имеет множество расширений (MVC, Data и т.д.) и активной поддерживается сообществом

Spring IoC

Центральной частью Spring является контейнер Inversion of Control (инверсия управления). Он нужен для:

- управления жизненным циклом объектов

- связывания их между собой

По сути, то же самое, что и Dependency Injection в C#

Сами объекты, находящиеся в контейнере (еще называемом контекстом), называются бинами (bean)

Чтобы установить Spring, воспользуемся магическими строчками:

<dependencies>

<dependency>

<groupId>org.springframework</groupId>

<artifactId>spring-context</artifactId>

<version>5.3.30</version>

</dependency>

</dependencies>

dependencies {

implementation('org.springframework:spring-context:5.3.30')

}

Зависимый объект может передаваться зависящему:

- напрямую через вызов метода контейнера

- через внедрение зависимостей (как аргумент конструктора, сеттера или свойства)

Чтобы Spring понял, какие классы должны стать бинами и участвовать в инверсии управления, их нужно

- указать в xml-конфиге

context.xml - аннотировать нужные сущности и указать пакет, в котором они находятся

- аннотировать нужные сущности и указать класс, который задает конфигурацию

Рассмотрим способ, включающий в себя xml-конфиг. Создадим две сущности - UserRepository и UserService:

public class UserRepository {

public String getData() {

return "Данные из репозитория";

}

}

public class UserService {

private final UserRepository userRepository;

private String endpoint;

public void setEndpoint(String endpoint) { this.endpoint = endpoint; }

public String getEndpoint() { return this.endpoint; }

// Конструктор для инъекции зависимости

public UserService(UserRepository userRepository) {

this.userRepository = userRepository;

}

public void processData() {

System.out.println("Обработка данных: " + userRepository.getData());

}

}

Далее заполняем наш context.xml:

<?xml version="1.0" encoding="UTF-8"?>

<beans xmlns="http://www.springframework.org/schema/beans"

xmlns:xsi="http://www.w3.org/2001/XMLSchema-instance"

xsi:schemaLocation="http://www.springframework.org/schema/beans

http://www.springframework.org/schema/beans/spring-beans.xsd">

<!-- Определяем бин для UserRepository -->

<bean id="userRepository" class="UserRepository"/>

<!-- Создаем бин UserService с инъекцией зависимости через конструктор -->

<bean id="userService" class="org.example.models.UserService">

<constructor-arg ref="userRepository"/>

<!-- Можно указать свойство -->

<property name="endpoint" value="google.com"/>

</bean>

</beans>

Теперь в Main.java достаем контекст из конфига и используем его:

import org.springframework.context.ApplicationContext;

import org.springframework.context.support.ClassPathXmlApplicationContext;

public class Main {

public static void main(String[] args) {

// Загрузка контекста Spring из xml-файла

ApplicationContext context = new ClassPathXmlApplicationContext("context.xml");

// Получаем бин UserService из контейнера

UserService userService = context.getBean("userService", UserService.class);

// Используем сервис

userService.processData();

}

}

Здесь мы вручную создали только ClassPathXmlApplicationContext - все остальные объекты создал Spring

Вместо xml-конфига, можно создать конфиг-класс, в котором вручную прокинуть зависимости:

@Configuration

public class AppConfig {

// Указываем, что это бин

@Bean

public UserRepository userRepository() {

return new UserRepository();

}

@Bean

public UserService userService() {

return new UserService(userRepository());

}

}

import org.springframework.context.ApplicationContext;

import org.springframework.context.support.ClassPathXmlApplicationContext;

public class Main {

public static void main(String[] args) {

ApplicationContext context = new AnnotationConfigApplicationContext(AppConfig.class);

UserService userService = context.getBean("userService", UserService.class);

userService.processData();

}

}

Это все надо делать ручками, поэтому перешли к сканированию пакета и аннотациям. Есть две аннотации, которые способствуют этому:

@Component- так помечаем класс, который будет участвовать во внедрении зависимости@Autowired- так помечаем метод (в том числе конструктор), которому будут передаваться зависимости из контейнера (также возможно приватное поле, которому будет передано зависимость)

В нашем примере это:

@Component

public class UserRepository {

public String getData() {

return "Данные из репозитория";

}

}

@Component

public class UserService {

private final UserRepository userRepository;

// Указываем, куда надо засунуть зависимость

@Autowired

public UserService(UserRepository userRepository) {

this.userRepository = userRepository;

}

public void processData() {

System.out.println("Обработка данных: " + userRepository.getData());

}

}

Далее аннотированные классы можно показать Spring либо с указанием пакета, в котором они находятся:

import org.springframework.context.ApplicationContext;

import org.springframework.context.support.ClassPathXmlApplicationContext;

public class Main {

public static void main(String[] args) {

// Загрузка контекста Spring из сканирования пакета

ApplicationContext context = new AnnotationConfigApplicationContext("org.example.models");

UserService userService = context.getBean("userService", UserService.class);

userService.processData();

}

}

либо через отдельный класс конфига (так называемого JavaConfig), в котором указать пакет:

@Configuration

@ComponentScan("org.example.models") // Указываем пакет для сканирования

public class AppConfig {

}

import org.springframework.context.ApplicationContext;

import org.springframework.context.support.ClassPathXmlApplicationContext;

public class Main {

public static void main(String[] args) {

ApplicationContext context = new AnnotationConfigApplicationContext(AppConfig.class);

UserService userService = context.getBean("userService", UserService.class);

userService.processData();

}

}

Вместо @Component можно использовать @Service, @Repository, @Controller, чтобы повысить читаемость

Если класс имеет несколько конструкторов, то можно добавить аннотацию @Primary для указания главного конструктора, которому будут передаваться зависимости

Чтобы задать скоуп (жизненный цикл) компонента, можно использовать аннотации:

@Scope("prototype")

@Scope("singleton")

// или

@Scope(ConfigurableBeanFactory.SCOPE_PROTOTYPE)

@Scope(ConfigurableBeanFactory.SCOPE_SINGLETON)

// ну и там еще есть request, session, application, websocket

или в xml-конфиге:

<bean id="userService" class="org.example.models.UserService" scope="singleton"/>

Как это работает?

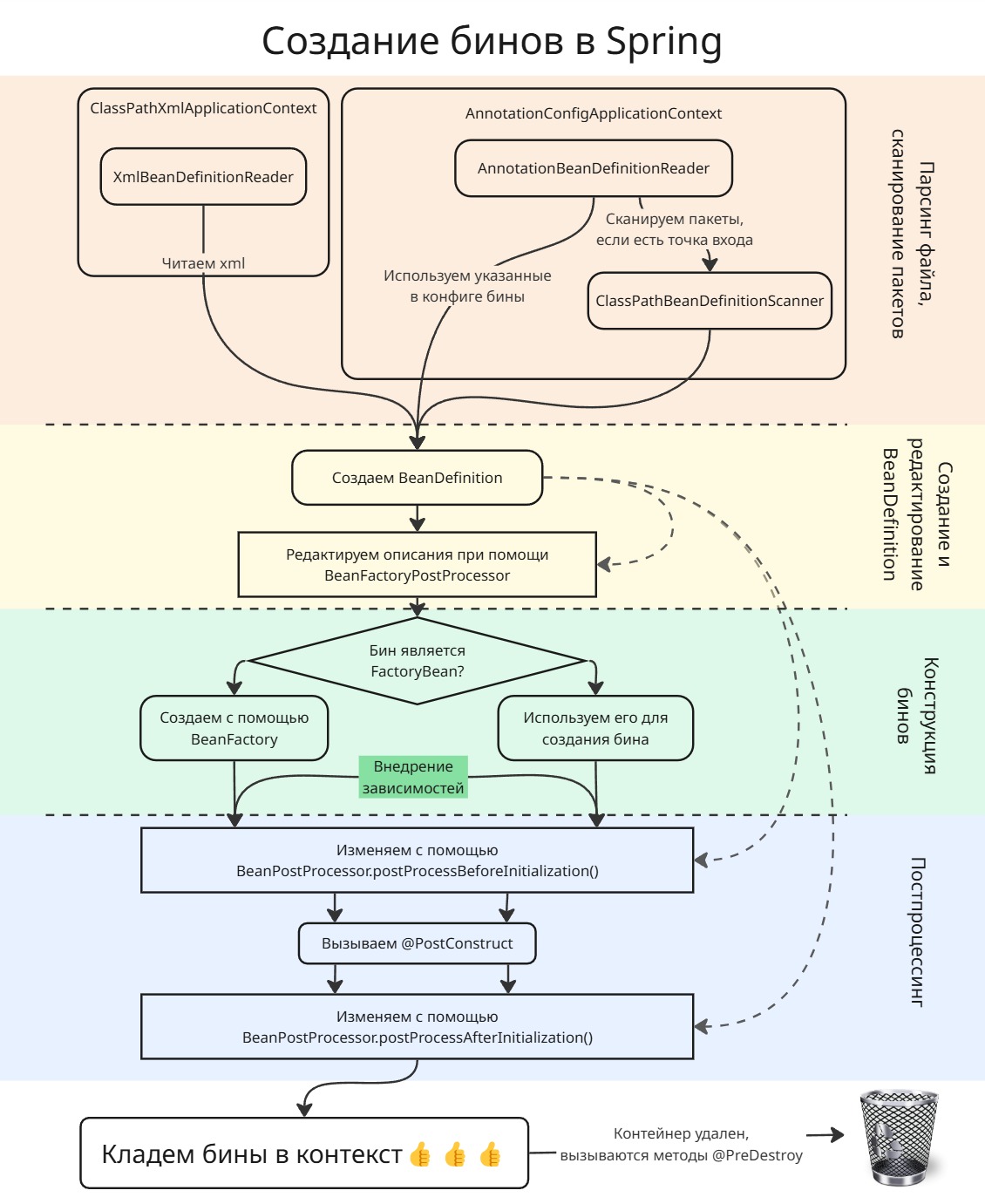

Сначала Spring достает все нужные ему сущности.

- Если это происходит через xml-файл, то используется объект класса

XmlBeanDefinitionReader. - Если это происходит через сканирование пакетов, то объект класса

AnnotationBeanDefinitionReaderищет все@Configuration, в которых могут быть дополнительные конфиги. ДалееClassPathBeanDefinitionScannerсканирует пакет на наличие@Component-классов

Теперь все считанные классы и интерфейсы запаковываются в объекты BeanDefinition, которые описывают будущие бины

По умолчанию, все BeanDefinition остаются не изменными, однако если в бинах случайно затесалась реализация BeanFactoryPostProcessor, то он используется для изменения описания бинов до их непосредственного создания. Пример такого BeanFactoryPostProcessor:

public class CustomBeanFactoryPostProcessor implements BeanFactoryPostProcessor {

@Override

public void postProcessBeanFactory(ConfigurableListableBeanFactory beanFactory) throws BeansException {

// Модифицируем существующий бин

BeanDefinition dbConfigDef = beanFactory.getBeanDefinition("dbConfig");

dbConfigDef.getPropertyValues().add("url", "jdbc:postgresql://default-host:5432/db");

// Создаем новый бин

GenericBeanDefinition newBeanDef = new GenericBeanDefinition();

newBeanDef.setBeanClassName("java.lang.String");

newBeanDef.getConstructorArgumentValues().addGenericArgumentValue("ЛОЛ!");

((DefaultListableBeanFactory)beanFactory).registerBeanDefinition("myBean", newBeanDef);

}

}

Все эти описания бинов хранятся в мапе. После этого они создаются при помощи BeanFactory

Если объект создается суперсложно, то его создание можно делегировать объекту класса, реализующего FactoryBean, например:

import org.springframework.beans.factory.FactoryBean;

// Создаем строки

public class StringFactoryBean implements FactoryBean<String> {

private String prefix;

private int counter = 0;

public void setPrefix(String prefix) {

this.prefix = prefix;

}

@Override

public String getObject() {

return prefix + "-" + (counter++);

}

@Override

public Class<?> getObjectType() {

return String.class;

}

@Override

public boolean isSingleton() {

return false;

}

}

Теперь можно получить объекты или фабрику:

String str = context.getBean("customStringFactory", String.class);

StringFactoryBean factory = context.getBean("&customStringFactory", StringFactoryBean.class);

ПОСЛЕ ЭТОГО, в ход вступают реализации BeanPostProcessor, которые могут дополнительно произвордить действия над созданными бинами перед и/или после инициализации (например, положить в прокси). Под инициализацией понимаются методы бинов, аннотированные @PostConstruct или указанные в xml как init-method: <bean id="userService" class="com.example.models.UserService" init-method="init"/>

import org.springframework.beans.BeansException;

import org.springframework.beans.factory.config.BeanPostProcessor;

import org.springframework.stereotype.Component;

@Component

public class CustomBeanPostProcessor implements BeanPostProcessor {

// Вызывается ПЕРЕД инициализацией бина

@Override

public Object postProcessBeforeInitialization(Object bean, String beanName) throws BeansException {

System.out.println("Преинициализация: " + beanName);

return bean;

}

// Вызывается ПОСЛЕ инициализации бина

@Override

public Object postProcessAfterInitialization(Object bean, String beanName) throws BeansException {

System.out.println("Постинициализация: " + beanName);

// Добавляем прокси для важного сервиса

if (bean instanceof ImportantService) {

return makeProxy(bean);

}

return bean;

}

private Object makeProxy(Object bean) {

System.out.println("Создаю прокси...");

return bean;

}

}

Теперь готовые бины кладутся в контекст

Когда контекст закрывается, у всех бинов вызывается метод, помеченный @PreDestroy или destroy-method="..." в xml

Лекция 7

Spring MVC

Spring MVC – модуль, который обеспечивает архитектуру паттерна Model - View - Controller (Модель - Отображение (или Вид) - Контроллер) при помощи слабо связанных готовых компонентов. Паттерн MVC разделяет аспекты приложения (логику ввода, бизнес-логику и логику UI), обеспечивая при этом свободную связь между ними.

- Model (Модель) инкапсулирует (объединяет) данные приложения, в целом они будут состоять из POJO (Plain Old Java Object - “Старый добрый Java-объект”, или бинов).

- View (Отображение, Вид) отвечает за отображение данных Модели, - как правило, генерируя HTML, которые мы видим в своём браузере.

- Controller (Контроллер) обрабатывает запрос пользователя, создаёт соответствующую Модель и передаёт её для отображения в Вид.

Spring MVC построен вокруг сервлета (объекта, который принимает запросы) DispatcherServlet, который распределяет запросы по контроллерам, а также предоставляет другие широкие возможности при разработке веб приложений.

DispatcherServlet уже интегрирован в Spring IoC, поэтому имеет доступ к встроенным в контекст бинам

DispatcherServlet, исходя из полученного HTTP-запроса, вызывает нужный контроллер, отмеченный аннотацией @Controller. Чтобы установить нужное действие по определенному эндпоинт, воспользуемся аннотацией @RequestMapping. В ней можно обозначить эндпоинт (и не только просто строка, а параметризированную (*тык*)), а также метод запроса

@Controller

@RequestMapping("/hello")

public class HelloControtter {

@RequestMapping(method = RequestMethod.GET)

public String printHetto(ModelMap model) {

model.addAttribute("message", "Hello Spring MVC Framework!");

return "hello";

}

}

Здесь вместо @RequestMapping(method = RequestMethod.GET) можно указать @GetMapping. Также есть другие специальные аннотации для типов запросов: @PostMapping, @PutMapping, @DeleteMapping, @PatchMapping

Еще пример:

@Controller

public class HelloController {

// Обработка GET-запроса на /hello

@GetMapping("/hello")

public String helloForm() {

return "hello-form"; // Вернет содержимое файла hello-form.html

}

// Обработка POST-запроса на /hello

@PostMapping("/hello")

public String sayHello(

@RequestParam("name") String name,

Model model

) {

// Здесь мы достаем имя из тела запроса и передаем его модели,

// контейнером, который передается слою с отображением

model.addAttribute("name", name.toUpperCase());

return "hello-response"; // Шаблон ответа

}

}

Готовые реализации интерфейса HandlerMapping могут в ответ на запрос дать нужный метод. По умолчанию есть:

-

RequestMappingHandlerMappingищет методы по аннотациям@RequestMappingи другим -

BeanNameUrlHandlerMappingиспользует параметры в аннотации@Bean(*тык*):@Configuration public class BeanNameUrlHandlerMappingConfig { @Bean BeanNameUrlHandlerMapping beanNameUrlHandlerMapping() { return new BeanNameUrlHandlerMapping(); } @Bean("/beanNameUrl") public WelcomeController welcome() { return new WelcomeController(); } }Или в xml-конфиге:

<bean class="org.springframework.web.servlet.handler.BeanNameUrlHandlerMapping" /> <bean name="/beanNameUrl" class="org.example.WelcomeController" />

Можно еще указать через SimpleUrlHandlerMapping - он использует явно добавленные методы:

@Configuration

public class WebConfig implements WebMvcConfigurer {

@Bean

public SimpleUrlHandlerMapping urlHandlerMapping() {

SimpleUrlHandlerMapping mapping = new SimpleUrlHandlerMapping();

// Создаем мапу

Map<String, Object> urlMap = new HashMap<>();

urlMap.put("/manual", manualHandler());

// Указываем, в какой мапе смотреть эндпоинты

mapping.setUrlMap(urlMap);

// Указываем порядок обработки

mapping.setOrder(1);

return mapping;

}

// Обработчик контроллера

@Bean

public HttpRequestHandler manualHandler() {

return (request, response) -> {

response.getWriter().write("Handled manually!");

};

}

}

Контроллер чаще всего пишем мы сами, поэтому у него нет привязки к интерфейсу из библиотеки Spring. Поэтому существует HandlerAdapter. Выглядит он так:

public interface HandlerAdapter {

boolean supports(Object handler);

ModelAndView handle(

HttpServletRequest request,

HttpServletResponse response,

Object handler) throws Exception;

long getLastModified(HttpServletRequest request, Object handler);

}

Перед непосредственной обработкой запроса вызывается supports, который возвращает, доступен ли обработчик handler к работе. Далее вызывается handle, который его обрабатывает и возвращает отображение

Помимо этого Spring MVC кладет в контейнер с бинами:

-

HandlerExceptionResolverрешает, что нужно выдавать, если контроллер бросил исключение (например, показывать дефолтную 404 страницу) -

ViewResolverпреобразовывает имена представления, возвращенное контроллером, в фактическое представление (ну еще рендеринг делает) -

LocaleResolverиLocaleContextResolverопределяют локаль и часовой пояс -

ThemeResolverдостает из куков, сессии, параметров запроса тему, а затем по ней судит, какие давать стили CSS, картинки и прочее -

MultipartResolverобрабатывает составные запросы (сContent-Type: multipart/form-data), сохраняет файлы в память/временную папку и передает их контроллеру вместе с другими текстовыми полями -

FlashMapManagerхранит данные одного запроса для использования в другом (например, между редиректами)

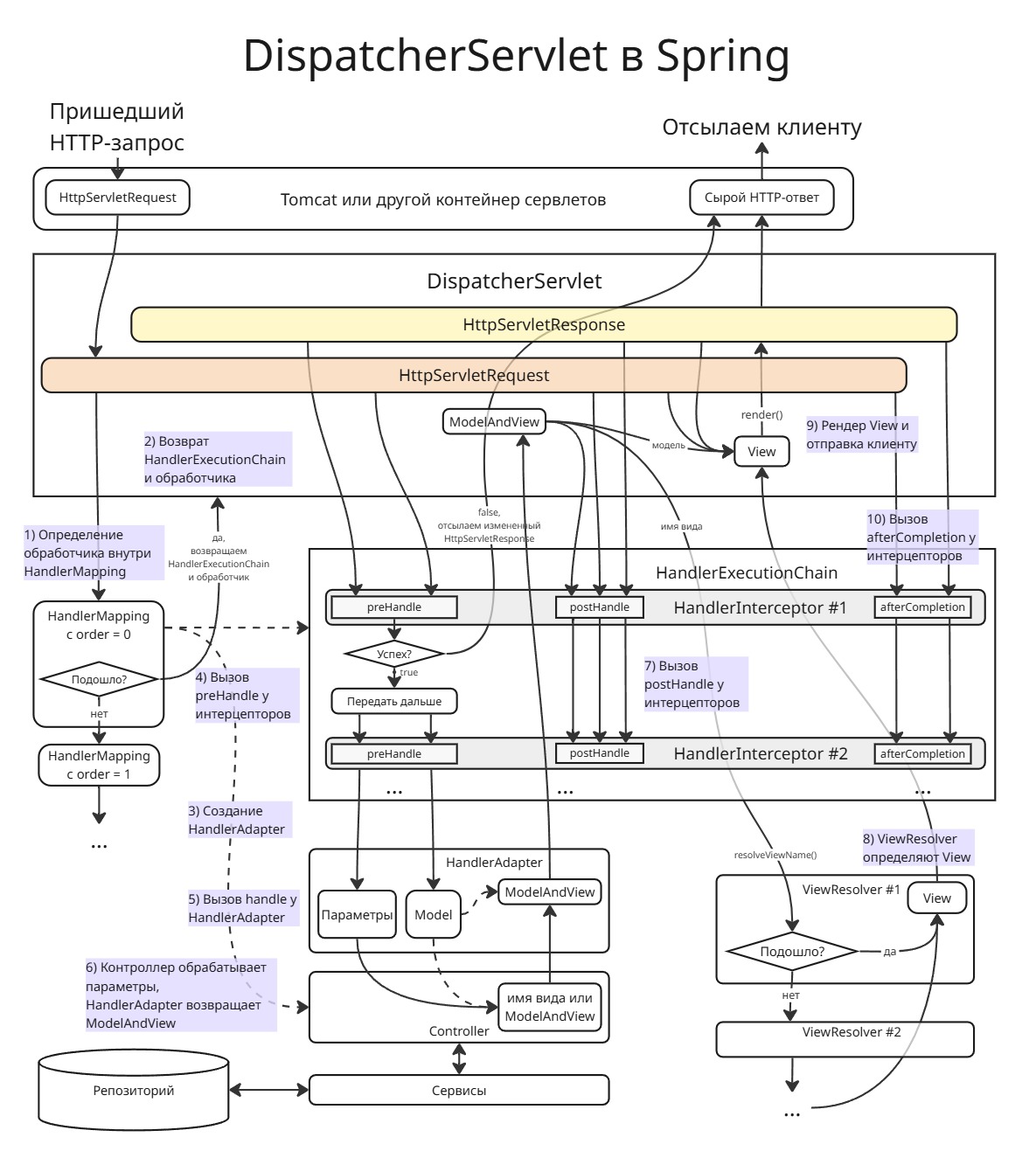

Разберем, как работает DispatcherServlet:

-

При получении HTTP-запроса

DispatcherServletдолжен определить при помощи доступных емуHandlerMappingкакому обработчику (методу контроллера) переправить запрос в видеHttpServletRequest. -

После определения контроллера внутри

HandlerMappingсписокHandlerExecutionChain(по сути цепочка обязанностей) из реализацийHandlerInterceptorвозвращается вместе с именем контроллера. Интерцепторы используются для пред- и постобработки запроса, а также после отсылки отображения клиенту -

Для обработчика создается обертка в виде

HandlerAdapter, реализации которых были найдены в контексте. По умолчанию, это:-

HttpRequestHandlerAdapterдля классов, реализующихHttpRequestHandler -

SimpleControllerHandlerAdapterдля классов, реализующих интерфейсController -

RequestMappingHandlerAdapterдля классов/методов, аннотированных@RequestMapping

-

-

Цепочка

HandlerExecutionChainвызывается, исполняя методыpreHandleу интерцепторов. Если какой-либо интерцептор вернетfalse, то запрос не дойдет до самого контроллера. Тогда считается, что запрос обработан интерцептором -

Когда все интерцепторы сказали

true, вызываетсяhandleуHandlerAdapter -

Контроллер принимает запрос, обрабатывает его и:

- сохраняет атрибуты отображения в

Model(например, черезmodel.addAttribute) и возращает имя отображения. - либо возвращает

ModelAndViewс именем отображения и атрибутами

Если контроллер хочет имплементировать REST API, то он сохранит все нужное в

Modelи вернетnull. Чтобы определить REST-методы, можно воспользоваться аннотациями@ResponseBodyдля методов или@RestControllerдля классов - сохраняет атрибуты отображения в

-

Теперь у интерцепторов цепочки

HandlerExecutionChainвызываютсяpostHandleдля постобработки -

При помощи интерфейса

ViewResolverDispatcherServletопределяет, какое отображение нужно использовать на основании полученного от контроллера имени -

После того, как отображение создано,

DispatcherServletотправляет данныеModelв виде атрибутов в отображение в методrender(), далее отображение в конечном итоге сохраняется вHttpServletResponse, а ответ далее идет отображаться в браузере -

В конце вызываются

afterCompletionу интерцепторов цепочки (например, для логгирования)

Если на каком-то этапе произошла ошибка, то реализации HandlerExceptionResolver возвращают какую-нибудь страничку с “что-то пошло не так”. По умолчанию в контексте есть:

-

ExceptionHandlerExceptionResolverобрабатывает исключения, передавая их аннотированным@ExceptionHandlerметодам:@ExceptionHandler(UserNotFoundException.class) public ResponseEntity<String> handleUserNotFound(UserNotFoundException ex) { return ResponseEntity .status(HttpStatus.NOT_FOUND) .body(ex.getMessage()); } -

ResponseStatusExceptionResolverможет отлавливать аннотированные@ResponseStatusисключения:@ResponseStatus(code = HttpStatus.NOT_FOUND, reason = "This user is not found") public class UserNotFoundException extends RuntimeException {}Здесь сообщение жестко зафиксировано, такое не получиться со стандартными исключениями, а также не вернуть какой-нибудь JSON

Также альтернативно можно кидать такие исключения в метода обработчика:

throw new ResponseStatusException( HttpStatus.NOT_FOUND, "User " + id + " not found!" ); -

DefaultHandlerExceptionResolverработает для стандартных Spring-исключений, возвращая подходящие для них HTTP коды статусов. Например, если вызвать GET для/user?id=abcпри имеющемся обработчике@GetMapping("/user") public User getUser(@RequestParam int id) { ... }DispatcherServletвыбросит ошибкуTypeMismatchException, аDefaultHandlerExceptionResolverвернетHTTP 400 Bad Request Body: "Failed to convert value of type 'java.lang.String' to required type 'int'"

Если HTTP-запрос пришел с заголовком Accept: <MIME_type>/<MIME_subtype>, то HttpMessageConverter будет искать доступные POJO доменной модели, пока не найдет соответствие с указанным в запросе типом. Далее HttpMessageConverter конвертирует тела входящих запросов в POJO, а в конце обработки запроса POJO в тела HTTP-ответов. По умолчанию, Spring Boot определяет набор дефолтных HttpMessageConverter

Лекция 8

Spring Boot

Spring Boot - набор утилит внутри Spring, автоматизирующих настройки фреймворка

Что должен сделать разработчик, чтобы запустить свое приложение без Spring Boot:

- В зависимости от характера приложения импортировать необходимые Spring-модули

- Импортировать библиотеку веб-контейнеров

- Импортировать необходимые сторонние библиотеки (например, Hibernate), при этом совместимые с выбранной версией Spring

- Конфигурировать компоненты DAO

- Определить класс, который загрузит необходимые конфигурации

Spring Boot же:

- Обеспечивает быстрый и широко доступный опыт начальной работы на Spring

- Делает возможным кастомизировать стандартное поведение

- Предоставляет ряд нефункциональных возможностей, таких как, тестирование, конфигурация, метрики и так далее

- Уходит от конфигом на XML

Все это работает благодаря:

- стартерам - готовым конфигурациям c бинами

- автоматической конфигурации библиотек

- преднастроенному Application Server для обеспечения серверного взаимодействия (в Spring используется Apache Tomcat)

- готовым рецептам для широко используемых подходов (метрики, внешняя конфигурация и т.д.)

Стартер

Стартер - это пакет зависимостей, собранных под одну задачу и оформленных как один артефакт для Maven или Gradle. Это ключевая особенность Spring Boot, упрощающая подключение библиотек и избавляющая от ручного выбора всех нужных зависимостей

Стартеры избавляют от ручного поиска всех зависимостей и обеспечивают совместимость библиотек между собой. Несколько популярных стартеров:

| Стартер | Назначение |

|---|---|

spring-boot-starter-web |

Для создания REST API и веб-приложений (включает Spring MVC, Tomcat) |

spring-boot-starter-data-jpa |

Для работы с базами данных через JPA/Hibernate |

spring-boot-starter-security |

Для добавления механизмов безопасности |

spring-boot-starter-test |

Для подключения JUnit, Mockito и других библиотек тестирования |

spring-boot-starter-thymeleaf |

Для серверной генерации HTML через шаблоны Thymeleaf |

spring-boot-starter-actuator |

Для мониторинга и управления приложением |

В spring-boot-starter-web входит Apache Tomcat. Apache Tomcat - комплект серверных программ, предназначенный для тестирования,отладки и исполнения веб-приложений на основе Java. Его обычно называют контейнером сервлетов - дополнительных компонентов, которые расширяют функциональность веб-сервера и позволяют ему выполнять приложения на языке Java.

Автоконфигурация

Второй превосходной возможностью Spring Boot является автоматическая конфигурация приложения.

После выбора подходящего starter-пакета, Spring Boot попытается автоматически настроить Spring-приложение на основе добавленных вами jar-зависимостей. Например:

import org.springframework.boot.SpringApplication;

import org.springframework.boot.autoconfigure.EnableAutoConfiguration;

import org.springframework.web.bind.annotation.GetMapping;

import org.springframework.web.bind.annotation.RestController;

import org.springframework.context.annotation.Configuration;

@Configuration

@EnableAutoConfiguration

@RestController

public class Main {

public static void main(String[] args) {

SpringApplication.run(Main.class, args);

}

@GetMapping("/")

public String hello() {

return "Hello world!";

}

}

С помощью аннотации @EnableAutoConfiguration Spring Boot может на основе добавленных зависимостей (например, spring-boot-starter-web) угадать, что и как именно нужно сконфигурировать

Другая аннотация, @SpringBootApplication, включает в себя аннотации @EnableAutoConfiguration и @ComponentScan (то есть включает автоконфигурацию и сканирование бинов)

Если сторонняя база данных не используется, а никаких сведений о подключении не предоставлено, Spring Boot автоматически настроит базу в памяти, без какой-либо дополнительной ручной конфигурации (при наличии H2 или HSQL драйверов)

В любой момент можно определить свою собственную конфигурацию, чтобы заменить определенные части автоконфигурации. Например, если добавить свой собственный бин DataSource, то средства поддержки встроенной базы данных по умолчанию отключатся.

Если необходимо узнать, какая автоконфигурация применяется в данный момент, можно запустить приложение с параметром --debug. Это позволит активировать отладочные журналы для выбранных основных диспетчеров журналирования и вывести отчет об условиях на консоль.

Можно указать, какие части автоконфигурации нужно исключить, например:

import org.springframework.boot.autoconfigure.SpringBootApplication;

import org.springframework.boot.autoconfigure.jdbc.DataSourceAutoConfiguration;

@SpringBootApplication(exclude = { DataSourceAutoConfiguration })

public class Main {

}

Initializr

Чтобы не тыкаться в xml или gradle файлике, гуглить самому зависимости и так далее, можно воспользоваться Spring Initializr (start.spring.io) - сайт, в котором можно выбрать нужную версию Spring, Java, подобрать нужные зависимости. Далее Spring Initializr сам генерирует шаблон проекта, автоматически делает конфиг с зависимостями и так далее

Инструменты разработчика

Модуль spring-boot-devtools включает в себя инструменты разработки, такие как:

-

Автоматическая перезагрузка (auto-restart) - при изменении классов или ресурсов приложение автоматически перезапускается (без полной перезагрузки JVM).

Это обеспечивает быструю обратную связь при разработке. Такой подход также известен как Hot Module Reload (“горячая” перезагрузка)

Перезагрузка работает при помощи основного и перезапускающего загрузчика:

- Классы, которые не будут изменяться (например, классы из сторонних jar-файлов), загружаются в основной загрузчик классов

- Классы, которые активно разрабатываются, загружаются в перезапускающий загрузчик классов

- Если приложение перезапускается, перезапускающий загрузчик классов единовременно используется, после чего создается новый, который подменяет старый. Такой подход означает, что перезапуск приложения обычно происходит гораздо быстрее, чем “холодный запуск”

- Отключение кеширования - кеш шаблонов (Thymeleaf, Freemarker), статики и т.п. отключается

- Улучшенные сообщения об ошибках - в stack trace отображаются более понятные причины ошибок

Модуль spring-boot-devtools выключается при свойстве spring.profiles.active=prod или при запуске приложения из jar-файла, чтобы не показывать пользователю подробности разработки

События при запуске

Spring Boot генерирует специальные события во время жизненного цикла запуска приложения. Эти события позволяют подключаться к нужным этапам старта и выполнять свою логику

ApplicationStartingEvent- Отправляется в самом начале, до инициализации контекста

- На этом этапе возможна только регистрация слушателей и инициализаторов

ApplicationEnvironmentPreparedEvent- Отправляется, когда доступна переменная

Environment

- Отправляется, когда доступна переменная

ApplicationContextInitializedEvent- Контекст уже создан, но бины ещё не загружены

- Выполнены

ApplicationContextInitializers

ApplicationPreparedEvent- Все определения бинов загружены

- Отправляется перед обновлением контекста

ApplicationStartedEvent- Контекст обновлён и запущен

- Но ещё не вызваны

ApplicationRunnerиCommandLineRunner(средства выполнения приложения и командной строки)

AvailabilityChangeEvent(LivenessState.CORRECT)- Обозначает, что приложение живое

- Следует сразу после

ApplicationStartedEvent

ApplicationReadyEvent- Приложение полностью готово

- Все раннеры (

ApplicationRunner,CommandLineRunner) вызваны

AvailabilityChangeEvent(ReadinessState.ACCEPTING_TRAFFIC)- Приложение готово принимать трафик

ApplicationFailedEvent- Отправляется, если во время старта возникло исключение

После ApplicationPreparedEvent и до ApplicationStartedEvent могут быть отправлены:

WebServerInitializedEvent- Отправляется, когда встроенный веб-сервер готов.

- Бывает двух видов:

ServletWebServerInitializedEvent— для обычного сервлета (Tomcat, Jetty и т.д.)ReactiveWebServerInitializedEvent— для реактивных приложений (Netty)

ContextRefreshedEvent- Отправляется, когда

ApplicationContextобновляется вручную или при запуске

- Отправляется, когда

Этот список касается только событий, относящихся к SpringApplicationEvent. Они особенно полезны для расширения поведения приложения на разных этапах запуска

Тестирование

Пакет spring-boot-starter-test включает в себя сразу библиотеки для работы с тестирование, а именно:

- JUnit 5 - стандартная библиотека для тестирования

- Spring Test и Spring Boot Test - средства поддержки утилит и интеграционных тестов для приложений Spring Boot. Модуль

spring-boot-testсодержит основные элементы, а модульspring-boot-test-autoconfigureподдерживает автоконфигурацию для тестов - AssertJ - для создания продвинутых ассертов

- Hamcrest - для создания объектов-сопоставителей (матчеров)

- Mockito - для мокирования объектов

- JSONassert - для проверки JSON-объектов

- JsonPath - XPath для JSON

Приложение Spring Boot – это ApplicationContext для Spring, поэтому для его тестирования не требуется ничего особенного, кроме тех операций, которые выполняются для ванильного контекста Spring

Spring Boot предусматривает аннотацию @SpringBootTest, которую по сути используется в качестве альтернативы стандартной аннотации @ContextConfiguration. Если Spring MVC доступен, конфигурируется обычный контекст приложения на основе MVC.

При тестировании приложений Spring Boot это обычно не требуется. Аннотации @*Test в Spring Boot осуществляют поиск вашей первичной конфигурации автоматически, если она не была определена вами явно. Алгоритм поиска начинает работу с пакета, содержащего тест, пока не найдет класс, аннотированный @SpringBootApplication или @SpringBootConfiguration

@SpringBootTest

@AutoConfigureMockMvc

public class HelloControllerTest {

@Autowired

private MockMvc mockMvc;

@Test

public void testHelloEndpoint() throws Exception {

mockMvc.perform(get("/hello"))

.andExpect(status().isOk())

.andExpect(content().string("Hello world!"));

}

}

По умолчанию аннотация @SpringBootTest не запускает сервер, а вместо этого создает имитационное окружение для тестирования конечных веб-точек (так называемых эндпоинтов).

Spring Data JPA

Spring Data JPA реализует готовые репозитории для доступа к сущностям через JPA. Конфиг для подключения к базе данных указывается в application.properties (или application.yml). По умолчанию Spring Boot подключает H2:

spring.datasource.url=jdbc:h2:mem:db

DB_CLOSE_DELAY=-1

spring.datasource.username=sa

spring.datasource.password=sa

С ними вместо написания своих DAO, использующих EntityManager, можно объявить класс репозитория, реализующий шаблонный интерфейс, а Spring Data JPA сам сделает реализации

public interface UserRepository extends CrudRepository<User, Long> {

}

Здесь User - класс, помеченный @Entity

Интерфейс CrudRepository задает базовые операции (создание, чтение, обновление, удаление). Интерфейс PagingAndSortingRepository предоставляет операции для пагинации и сортировки сущностей. Другой интерфейс, JpaRepository, является их объединением.

Класс, реализующие эти интерфейс, автоматически попадают в контейнер внедрения зависимостей

Традиционно сущности для JPA задаются в persistence.xml, но, используя Spring, так можно не делать - Spring сам их найдет по умолчанию с автоконфигурацией

Можно расширить функционал репозитория, при этом не писать своей собственной реализации. Работает это так: Spring по названию метода и аргумента может понять, какой ему нужно сгенерировать SQL-запрос, чтобы все заработало

Метод определяется по ключевым словам в его названии:

| Ключевое слово | Описание / Поведение | Пример метода | SQL-аналог |

|---|---|---|---|

And |

И | findByUsernameAndEmail |

WHERE username = ? AND email = ? |

Or |

ИЛИ | findByUsernameOrEmail |

WHERE username = ? OR email = ? |

Is, Equals |

Проверка на равенство (можно опустить) | findByUsername, findByUsernameIs |

WHERE username = ? |

Between |

Между двумя значениями | findByAgeBetween(18, 30) |

WHERE age BETWEEN 18 AND 30 |

LessThan, Before |

Меньше | findByAgeLessThan(18) |

WHERE age < 18 |

GreaterThan, After |

Больше | findByAgeGreaterThan(30) |

WHERE age > 30 |

LessThanEqual |

Меньше или равно | findByAgeLessThanEqual(18) |

WHERE age <= 18 |

GreaterThanEqual |

Больше или равно | findByAgeGreaterThanEqual(30) |

WHERE age >= 30 |

IsNull |

Значение = NULL | findByEmailIsNull() |

WHERE email IS NULL |

IsNotNull, NotNull |

Значение ≠ NULL | findByEmailIsNotNull() |

WHERE email IS NOT NULL |

Like |

SQL LIKE выражение (с %, _) | findByEmailLike("%@gmail.com") |

WHERE email LIKE '%@gmail.com' |

NotLike |

LIKE NOT | findByEmailNotLike("%test%") |

WHERE email NOT LIKE '%test%' |

StartingWith / StartsWith |

Начинается с | findByUsernameStartingWith("A") |

WHERE username LIKE 'A%' |

EndingWith / EndsWith |

Заканчивается на | findByUsernameEndingWith("ov") |

WHERE username LIKE '%ov' |

Containing / Contains |

Содержит (эквивалент %...%) |

findByUsernameContaining("adm") |

WHERE username LIKE '%adm%' |

In |

В списке | findByIdIn(List<Long> ids) |

WHERE id IN (...) |

NotIn |

Не в списке | findByUsernameNotIn(List<String> names) |

WHERE username NOT IN (...) |

True, False |

Для булевых полей | findByActiveTrue() |

WHERE active = true |

OrderBy |

Сортировка | findByAgeOrderByUsernameAsc() |

ORDER BY username ASC |

Top, First |

Лимит количества результатов | findTop3ByOrderByAgeDesc() |

LIMIT 3 |

ExistsBy |

Проверка на существование | existsByUsername(String username) |

SELECT COUNT ... > 0 |

CountBy |

Подсчёт | countByEmail(String email) |

SELECT COUNT(*) WHERE email = ? |

// Поиск по одному полю

Optional<User> findByUsername(String username);

// Поиск по нескольким полям (и)

Optional<User> findByUsernameAndEmail(String username, String email);

// Поиск с сортировкой

List<User> findByAgeGreaterThanOrderByUsernameAsc(int age);

// Проверка на существование

boolean existsByEmail(String email);

// Подсчёт

long countByAgeLessThan(int age);

Вместо findBy, возвращающего Optional<T>, может быть:

readByделает то же самоеgetByто же самое, но семантически подразумевает, что сущность точно существуетqueryByделает то же самоеcountByвозвращает количество сущностейexistsByвозвращает true, если сущность есть

Если очень хочется указывать свои шаблоны SQL-запросов, то это можно делать с помощью аннотации @Query

@Query("SELECT u.username, u.email FROM User u WHERE u.age >= :minAge")

List<Object[]> findUsernamesAndEmailsByAge(@Param("minAge") int minAge);

Если прям ОЧЕНЬ хочется, то можно реализовать свои методы:

public interface UserRepositoryCustom {

List<User> findUsersWithLongUsername(int minLength);

}

@Repository

public class UserRepositoryCustomImpl implements UserRepositoryCustom {

@PersistenceContext

private EntityManager entityManager;

@Override

public List<User> findUsersWithLongUsername(int minLength) {

return entityManager.createQuery(

"SELECT u FROM User u WHERE LENGTH(u.username) > :minLength", User.class)

.setParameter("minLength", minLength)

.getResultList();

}

}

Лекция 9

Spring Security

Spring Security – мощный фреймворк для обеспечения безопасности Java-приложений в экосистеме Spring. Он предоставляет комплексные сервисы безопасности (аутентификация, авторизация, фильтрация запросов и т.д.) для корпоративных веб-приложений. Spring Security возник из-за того, что встроенные в Java EE механизмы безопасности (Servlet/EJB) оказались слишком ограниченными и мало портируемыми для реальных задач. С помощью Spring Security можно гибко настроить проверку личности пользователя, разграничение прав доступа, защиту от CSRF, встроенную поддержку «remember-me», сессию, а также десятки других возможностей. Фреймворк автоматически интегрируется со Spring MVC/Boot и даже сам генерирует простые страницы логина/выхода по умолчанию

Основные понятия:

-

Аутентификация (Authentication). Процесс проверки и установления личности пользователя (principal) приложения. Обычно происходит проверка логина и пароля. Spring Security поддерживает множество моделей аутентификации (формовая, HTTP Basic/Digest, LDAP, JWT, OAuth2 и др.), при этом наиболее часто после успешного входа формируется объект

Authentication, содержащий информацию о пользователе -

Авторизация (Authorization). Процесс принятия решения, разрешено ли аутентифицированному пользователю выполнить запрошенное действие или получить ресурс. После аутентификации Spring Security сравнивает роли/привилегии пользователя с требованиями защищаемого ресурса. Например, проверяется, имеет ли пользователь роль

ADMINили другую необходимую полномочие. -

Фильтры безопасности (Security Filters). Весь механизм Spring Security построен как цепочка Servlet-фильтров. Эти фильтры перехватывают каждый HTTP-запрос до попадания в контроллер, проверяя аутентификацию и авторизацию. Spring Security по умолчанию подключается в FilterChain через

DelegatingFilterProxy. Фильтры могут, например, перенаправлять на страницу логина, если пользователь не аутентифицирован, или блокировать доступ, если прав недостаточно -

Контекст безопасности (Security Context). Информация о текущем пользователе (принципале) хранится в объекте

SecurityContext, привязанном к текущему потоку исполнения. Обычно Spring Security используетSecurityContextHolderсThreadLocalдля хранения текущегоAuthentication(информация о пользователе и его правах). Благодаря этому из любого места кода (в рамках одного HTTP-запроса) можно получить текущий контекст безопасности и узнать, кто залогинен. Spring Security самостоятельно очищает этот контекст после завершения обработки запроса -

Роли и привилегии (Roles and Authorities). В Spring Security права доступа пользователя задаются через «предоставленные полномочия» (

GrantedAuthority). Роли – это лишь особый тип полномочий. По соглашению роли записываются с префиксомROLE_(например, роль администратора называетсяROLE_ADMIN). Если в конфигурации указывается требованиеhasRole("ADMIN"), то Spring Security автоматически проверит, есть ли у пользователя полномочиеROLE_ADMIN. Таким образом «роль» – это только строковый маркер («ROLE_X»), а реальное решение принимается сравнением значенийGrantedAuthorityу текущегоAuthenticationс требуемыми атрибутами

Spring Security работает с помощью фильтров. Фильтры последовательно обрабатывают пришедший HTTP-запрос и решают, обрабатывать его дальше или нет. Фильтры образуют цепочку обязанностей:

@Configuration

@EnableWebSecurity

@EnableMethodSecurity

@RequiredArgsConstructor

public class SecurityConfig {

@Bean

@SneakyThrows

public SecurityFilterChain securityFilterChain(HttpSecurity http) {

return http

.csrf().disable()

.cors().disable()

.authorizeHttpRequests(customizer -> customizer.anyRequest().authenticated())

.httpBasic()

.authenticationEntryPoint((request, response, authException) -> response.sendError(401))

.and()

.build();

}

}

В этом примере мы:

- Отключаем для проекта защиту от атак CSRF (Cross-site request forgery). Атака CSRF работает так: вредоносный сайт отправляет от лица пользователя (сессия которого активна и находится в куки-файлах) POST-запрос, например, банку, а банк считает этот запрос валидным. Несмотря на то, что вредоносный сайт не видит куки, они автоматически прикрепляются в запросе браузером. Spring же для защиты от такого в запросе требует токен, который генерирует вместе с сессией

- Отключаем CORS (Cross-Origin Resource Sharing). По умолчанию браузер запрещают JavaScript-коду обращение к другим доменам, поэтому существует CORS: при запросе к отличающемуся домену сервер должен отправить в заголовке HTTP-запроса

Access-Control-Allow-Origin: https://example.com. Тогда браузер обработает его - Делаем так, что все запросы должны исходить от авторизованного пользователя. Иначе возвращаем 401 Unauthorized или перенаправляем на страницу с авторизацией

- Возвращаем настроенную цепочку фильтров

По умолчанию, фильтры такие:

WebAsyncManagerIntegrationFilter-Интеграция безопасности с асинхронными запросами (например,@Async)SecurityContextPersistenceFilter- Загружает/сохраняетSecurityContextвHttpSession(или другую стратегию) устанавливает его вSecurityContextHolderдля текущего потока. Если контекст ещё не создан (первый запрос), он создаёт новый «пустой» контекст. Это обеспечивает получение информации о ранее вошедшем пользователеHeaderWriterFilter- Добавляет HTTP-заголовки безопасности (например,X-Frame-Options)CsrfFilter- Обрабатывает защиту от CSRF-атак (если включена)LogoutFilter- Обрабатывает POST-запросы на/logout. В этом случае удаляется CSRF-токен, завершается сессия, чиститсяSecurityContextHolder-

BasicAuthenticationFilter- Обрабатывает HTTP Basic авторизацию (если используется): извлекает логин\пароль и передает их вAuthenticationManagerAuthenticationManagerпредставляет из себя интерфейс с одним методом:Authentication authenticate(Authentication authentication) throws AuthenticationException;В нашем случае имплементацией

AuthenticationбудетUsernamePasswordAuthenticationTokenAuthenticationManagerполучает объектAuthentication(например, с username и password) и передаёт его в подходящийAuthenticationProvider, чтобы проверить подлинность.AuthenticationProviderсодержит в себе два метода:Authentication authenticate(Authentication authentication) throws AuthenticationException; boolean supports(Class<?> authentication);Обычно реализуется через

ProviderManager, который внутри содержит списокAuthenticationProvider‘ов.AuthenticationProviderпроверяет, поддерживает ли он данный типAuthenticationс помощью методаsupports. Если поддерживает — проверяет credentials в методеauthenticate(например, сверяет пароль и логин), а если аутентификация успешна — возвращает полностью заполненный объектAuthenticationс флагомauthenticated=true.Если все провайдеры выкинул исключение,

ProviderManagerвыброситAuthenticationManagerпоследнее исключениеДалее фильтр сохраняет полученный

AuthenticationвSecurityContextHolder. Если выброситсяAuthenticationExceptionот провайдеров, то будет сброшен контекст, и вызоветсяAuthenticationEntryPoint RequestCacheAwareFilter- Кэширует защищённые запросы, чтобы потом на них вернуть пользователя:- Пользователь заходит на защищенный url.

- Его перекидывает на страницу логина.

- После успешной авторизации пользователя перекидывает на страницу которую он запрашивал в начале.

SecurityContextHolderAwareRequestFilter- Делаетrequest.isUserInRole(...)иgetUserPrincipal()работающимиAnonymousAuthenticationFilter- Назначает “анонимного пользователя”, если пользователь не аутентифицирован. Фильтр заполняет объектSecurityContextHolderанонимной аутентификациейAnonymousAuthenticationTokenс рольюROLE_ANONYMOUS. Это гарантирует что вSecurityContextHolderбудет объектSessionManagementFilter- Производится действия, связанные с сессией. Это может быть:- Смена идентификатора сессии

- Ограничения количества одновременных сессий

- Сохранение

SecurityContextвsecurityContextRepository

В обычном случае происходит следующее:

SecurityContextRepositoryс дефолтной реализациейHttpSessionSecurityContextRepositoryсохраняетSecurityContextв сессию. ВызываетсяsessionAuthenticationStrategy.onAuthentication:- По умолчанию, включена защита от Session Fixation Attack, то есть после аутентификации меняется идентификатор сессии.

- Если был передан CSRF-токен, генерируется новый CSRF-токен

ExceptionTranslationFilter- Перехватывает исключения (например, недостаточно прав или ошибка аутентификации) из более глубоких фильтров. Если пользователь не аутентифицирован,ExceptionTranslationFilterперенаправит его на точку входа (например, на страницу логина) или вернёт HTTP 401/403. Этот механизм обеспечивает корректное реагирование на проблемы с безопасностью.FilterSecurityInterceptor- Проверяет соответствие между требуемыми правами доступа и правами текущего пользователя. Здесь происходит сравнение атрибутов защищаемого ресурса (например, требуемой роли) с полномочиями вAuthentication. Если прав достаточно, запрос пропускается к контроллеру, иначе – генерируется отказ в доступе.

После обработки запроса всеми фильтрами результат либо отдается клиенту (запрос был разрешён), либо возвращается ошибка безопасности. При этом при завершении запроса SecurityContextPersistenceFilter может сохранить обновлённый SecurityContext (например, если пользователь только что вошёл) обратно в сессию.

Также есть:

RememberMeAuthenticationFilter, читающий куки и восстанавливающий аутентификациюOAuth2LoginAuthenticationFilterдля OAuth2-аутентификации

Конфигурация Spring Security может выполняться чисто на Java (без XML). Современный подход – объявлять бины SecurityFilterChain и UserDetailsService или WebSecurityCustomizer. Начиная с Spring Security 5.7 класс WebSecurityConfigurerAdapter считается устаревшим, и вместо него рекомендуется использовать SecurityFilterChain. Например, класс конфигурации может выглядеть так:

@Configuration

public class SecurityConfig {

@Bean

public SecurityFilterChain filterChain(HttpSecurity http) throws Exception {

http

.authorizeHttpRequests(authz -> authz.anyRequest().authenticated())

.httpBasic(Customizer.withDefaults());

return http.build();

}

@Bean

public InMemoryUserDetailsManager userDetailsService() {

UserDetails user = User.withDefaultPasswordEncoder()

.username("user")

.password("password")

.roles("USER")

.build();

return new InMemoryUserDetailsManager(user);

}

}

В этом примере все запросы к приложению требуют аутентификации (anyRequest().authenticated()), и используется HTTP Basic для ввода логина/пароля. Пользователь с именем user, паролем password и ролью USER хранится в памяти внутри InMemoryUserDetailsManager. Метод withDefaultPasswordEncoder() упрощает демонстрацию (пароль автоматически кодируется), но не предназначен для продакшен-использования – в реальном приложении следует хранить пароль в безопасном зашифрованном виде.

При подобной конфигурации Spring Boot создаст простую стандартную форму логина/логаута по умолчанию. Как только разработчик добавляет Spring Security, по умолчанию все URL блокируются и требуют входа (пока не настроено иное поведение). Поведение фильтров (какие URL защищать, какие – открыты) меняется через методы authorizeHttpRequests(), permitAll(), hasRole() и т.д. Дополнительно можно настраивать CSRF-защиту, правила для статических ресурсов, перенаправления и прочее через объект HttpSecurity.

Если не настраивать пользователей вручную, Spring Boot по умолчанию создаст одного пользователя с именем user и сгенерированным паролем, который выводится в логи при запуске. Но обычно для учебных примеров и небольших приложений проще явно указать своих пользователей (как выше).

Продвинутые возможности:

- JWT (JSON Web Tokens). Часто Spring Security используют в безсессионном режиме для REST-API. В таком случае после логина выдаётся JWT-токен, который клиент отправляет в заголовке запроса. Затем на каждом запросе можно собственным фильтром извлекать JWT, проверять его подпись и создавать